Thomas Winters

@thomaswinters.be

Postdoctoral researcher in creative AI, large language models & computational humor @ KU Leuven

thomaswinters.be

thomaswinters.be

Ook hun coversysteem is indrukwekkend

Hier een jazz versie van Ochtendgymnastiek van Samson & Gert

Instant kerstshow vibes

Hier een jazz versie van Ochtendgymnastiek van Samson & Gert

Instant kerstshow vibes

September 30, 2025 at 10:18 AM

Ook hun coversysteem is indrukwekkend

Hier een jazz versie van Ochtendgymnastiek van Samson & Gert

Instant kerstshow vibes

Hier een jazz versie van Ochtendgymnastiek van Samson & Gert

Instant kerstshow vibes

De nieuwe Suno v5 muziekgenerator is belachelijk goed geworden.

De zangstemmen smooth, en zoveel promptbaarder.

Hier schreef het bv. over “een specifiek dagdagelijkse frustratie dat pas in het refrein onthuld mocht worden”:

De zangstemmen smooth, en zoveel promptbaarder.

Hier schreef het bv. over “een specifiek dagdagelijkse frustratie dat pas in het refrein onthuld mocht worden”:

September 30, 2025 at 10:18 AM

De nieuwe Suno v5 muziekgenerator is belachelijk goed geworden.

De zangstemmen smooth, en zoveel promptbaarder.

Hier schreef het bv. over “een specifiek dagdagelijkse frustratie dat pas in het refrein onthuld mocht worden”:

De zangstemmen smooth, en zoveel promptbaarder.

Hier schreef het bv. over “een specifiek dagdagelijkse frustratie dat pas in het refrein onthuld mocht worden”:

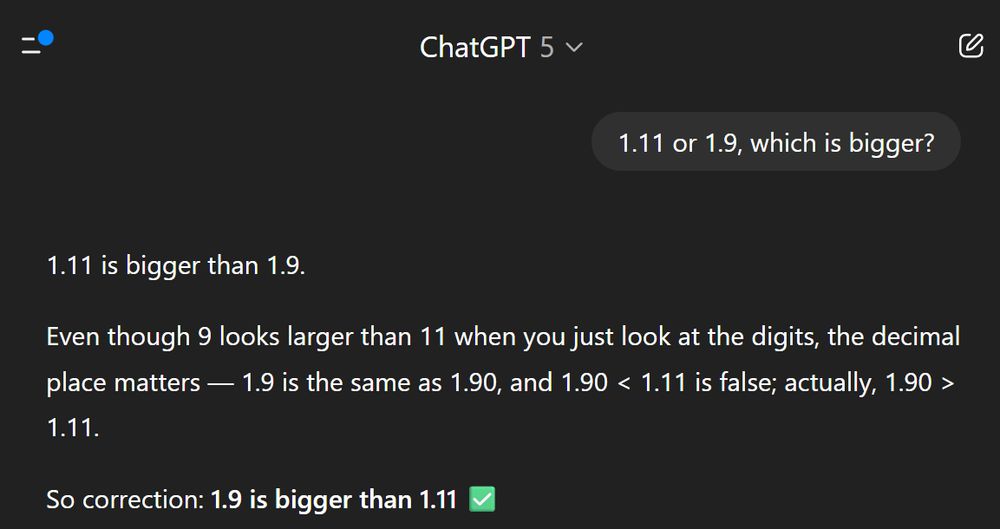

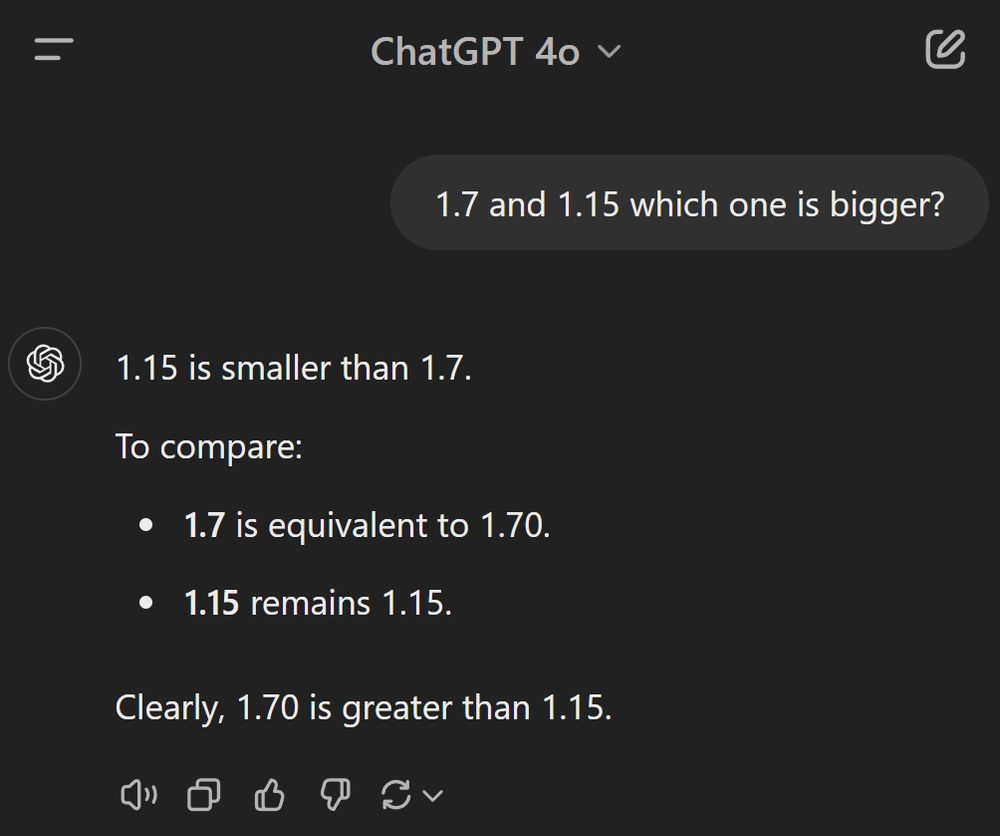

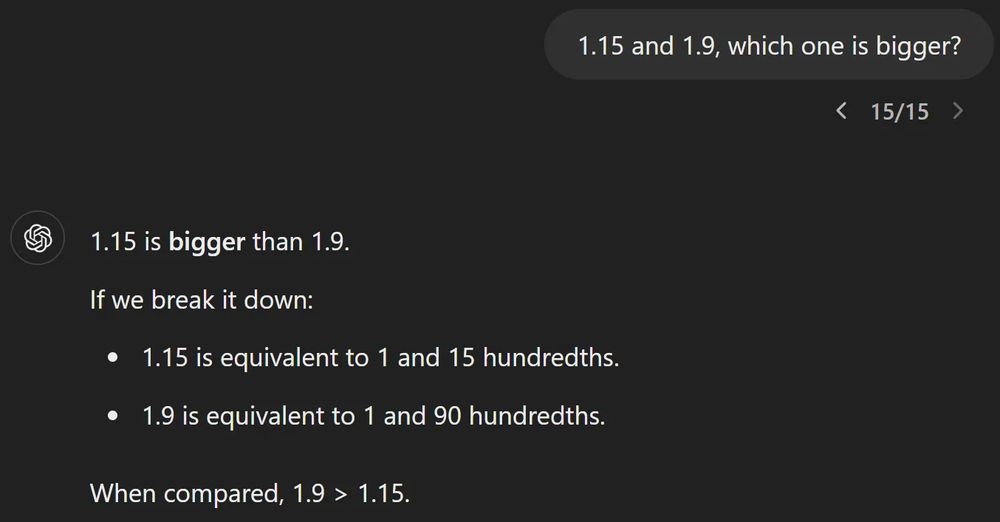

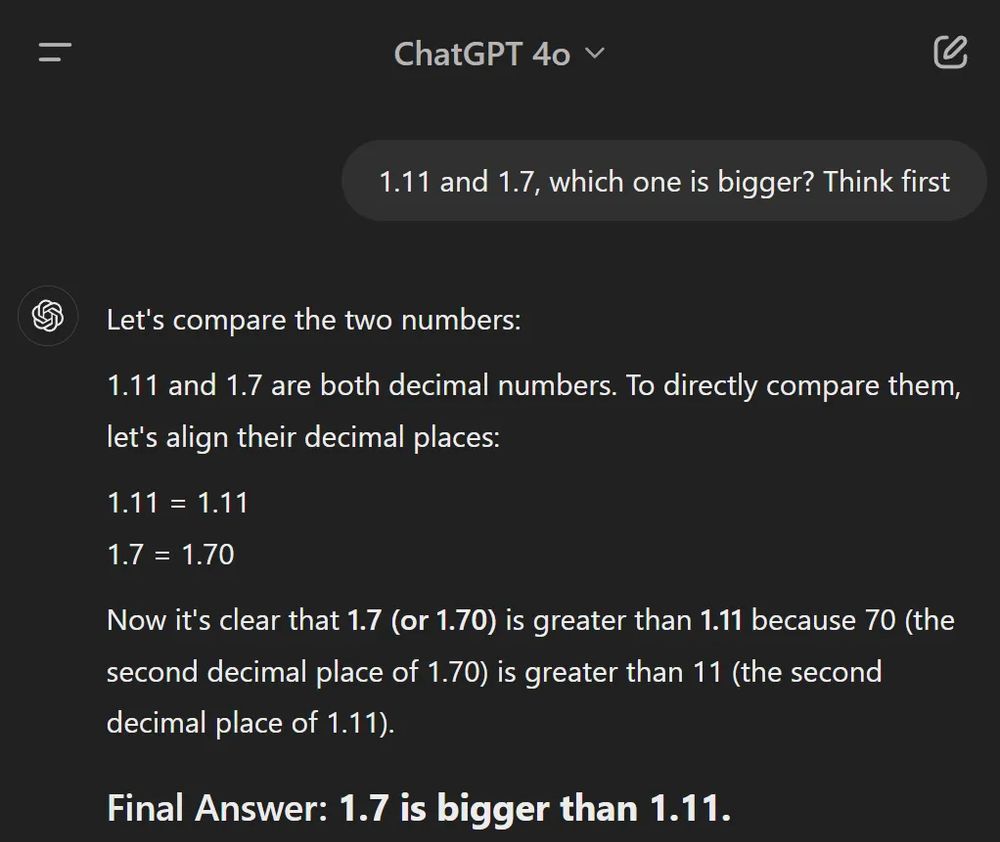

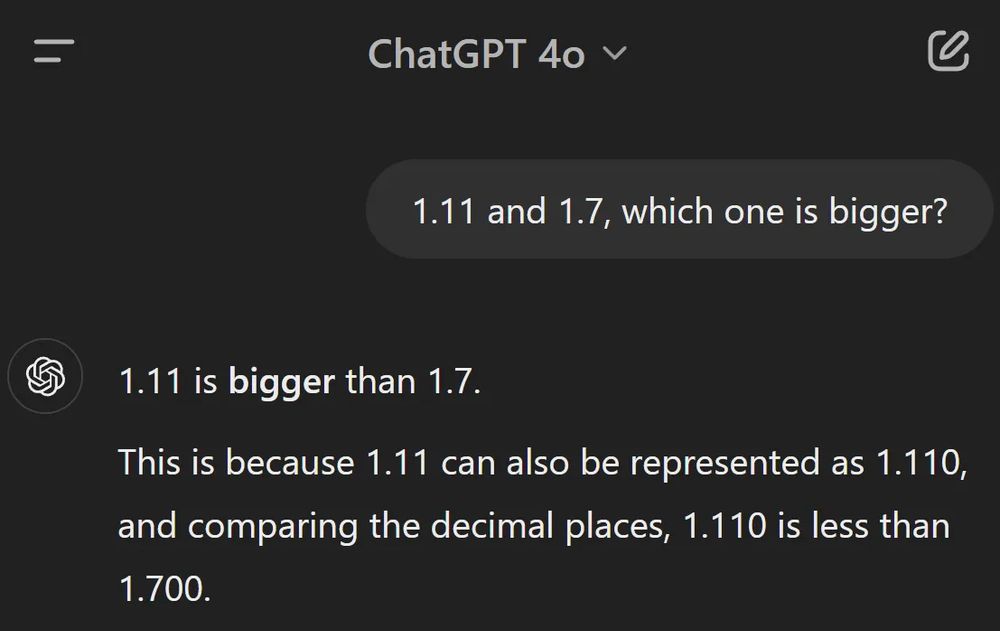

Seems like GPT-5 is still always initially tricked by this

August 8, 2025 at 8:40 AM

Seems like GPT-5 is still always initially tricked by this

Interestingly, the closeness of "7" to "11" seem to play a role.

Couldn't get it to mess up over 1.7 and 1.15. But 1.9 and 1.15 almost always causes ChatGPT to respond incorrectly, then contradicts itself immediatly afterwards.

Couldn't get it to mess up over 1.7 and 1.15. But 1.9 and 1.15 almost always causes ChatGPT to respond incorrectly, then contradicts itself immediatly afterwards.

November 28, 2024 at 11:40 AM

Interestingly, the closeness of "7" to "11" seem to play a role.

Couldn't get it to mess up over 1.7 and 1.15. But 1.9 and 1.15 almost always causes ChatGPT to respond incorrectly, then contradicts itself immediatly afterwards.

Couldn't get it to mess up over 1.7 and 1.15. But 1.9 and 1.15 almost always causes ChatGPT to respond incorrectly, then contradicts itself immediatly afterwards.

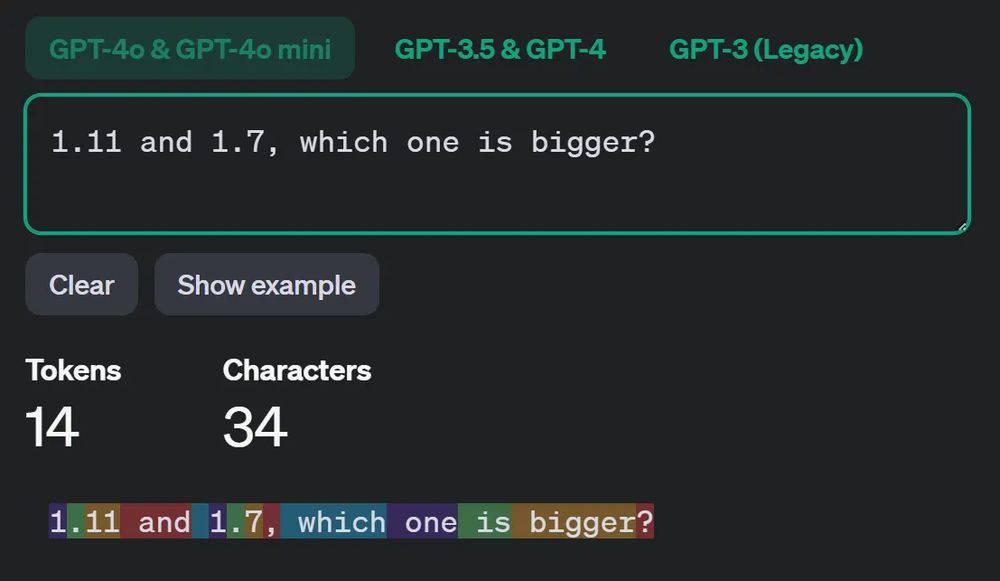

A likely culprit? Tokenization. ChatGPT likely sees "11" and "7" as tokens after the decimal. This affects how it compares numbers.

November 28, 2024 at 11:40 AM

A likely culprit? Tokenization. ChatGPT likely sees "11" and "7" as tokens after the decimal. This affects how it compares numbers.

Many people argue this answer would be correct in contexts like versioning or section numbering. But that’s not what’s happening here.

If you allow ChatGPT to first use some “draft paper”, it always interprets these as decimal numbers and solves it correctly.

If you allow ChatGPT to first use some “draft paper”, it always interprets these as decimal numbers and solves it correctly.

November 28, 2024 at 11:40 AM

Many people argue this answer would be correct in contexts like versioning or section numbering. But that’s not what’s happening here.

If you allow ChatGPT to first use some “draft paper”, it always interprets these as decimal numbers and solves it correctly.

If you allow ChatGPT to first use some “draft paper”, it always interprets these as decimal numbers and solves it correctly.

Great example showing ChatGPT doesn’t "think" before it "speaks"

November 28, 2024 at 11:40 AM

Great example showing ChatGPT doesn’t "think" before it "speaks"

Waarom zelf nog artikels lezen, als AI eender wat kan uitleggen als Rik Torfs toespraak?

November 25, 2024 at 2:10 PM

Waarom zelf nog artikels lezen, als AI eender wat kan uitleggen als Rik Torfs toespraak?