Deep Learning for Learning Graph Representations

Deep Learning for Learning Graph Representations

Structural Deep Network Embedding

Structural Deep Network Embedding

Graph Embedding Techniques, Applications, and Performance: A Survey

Graph Embedding Techniques, Applications, and Performance: A Survey

A High-Scale Assessment of Social Media and Mainstream Media in ScientificCommunication

A High-Scale Assessment of Social Media and Mainstream Media in ScientificCommunication

The World Is Bigger! A Computationally-Embedded Perspective on the Big World Hypothesis

The World Is Bigger! A Computationally-Embedded Perspective on the Big World Hypothesis

Attention Is All You Need

Attention Is All You Need

metapath2vec: Scalable Representation Learning for Heterogeneous Networks投稿

metapath2vec: Scalable Representation Learning for Heterogeneous Networks投稿

実証的にも明示的に浅いモデルに2次よりも大きい情報を入れているGraRepよりも性能が良いと主張されている。node2vecやOu et al.とおなじ、KDD'16で発表。node2vecはいわゆる浅いモデル。

Structural Deep Network Embedding

実証的にも明示的に浅いモデルに2次よりも大きい情報を入れているGraRepよりも性能が良いと主張されている。node2vecやOu et al.とおなじ、KDD'16で発表。node2vecはいわゆる浅いモデル。

Structural Deep Network Embedding

ノードの特徴量(テキストやタンパク質の情報)を線形変換して、近傍のノードを重視しながら層を積み重ねる。

マスク付きセルフアテンションによって、近傍のノードのみに注目して学習を行う。

これにより、行列演算のような重い処理を使わずに、グラフの局所的な構造(誰と繋がっているか)を自然に学習に取り込む事ができる。

Graph Attention Networks

petar-v.com/GAT/

ノードの特徴量(テキストやタンパク質の情報)を線形変換して、近傍のノードを重視しながら層を積み重ねる。

マスク付きセルフアテンションによって、近傍のノードのみに注目して学習を行う。

これにより、行列演算のような重い処理を使わずに、グラフの局所的な構造(誰と繋がっているか)を自然に学習に取り込む事ができる。

Graph Attention Networks

petar-v.com/GAT/

The distinctive innovation patterns and network embeddedness of scientific prizewinners

The distinctive innovation patterns and network embeddedness of scientific prizewinners

設定したステップ毎に行列分解し、concatしてKステップ毎の情報を明示的に保持。DeepWalkはKステップなど同じ空間に同じ空間に射影するのが問題と指摘し、クラスタリングの精度で提案手法は勝ると主張。比較がフェアになるように、DeepWalkにおいてエッジの重みでサンプルしたE-SGNSを提案し比較。

GraRep: Learning Graph Representations with Global Structural Information

設定したステップ毎に行列分解し、concatしてKステップ毎の情報を明示的に保持。DeepWalkはKステップなど同じ空間に同じ空間に射影するのが問題と指摘し、クラスタリングの精度で提案手法は勝ると主張。比較がフェアになるように、DeepWalkにおいてエッジの重みでサンプルしたE-SGNSを提案し比較。

GraRep: Learning Graph Representations with Global Structural Information

Links that speak: The global language network and its association with global fame

Links that speak: The global language network and its association with global fame

Network representation learning with rich text information

Network representation learning with rich text information

Asymmetric Transitivity Preserving Graph Embedding

Asymmetric Transitivity Preserving Graph Embedding

Anatomy of US inequality

papers.ssrn.com/sol3/papers....

Anatomy of US inequality

papers.ssrn.com/sol3/papers....

Community Aware Random Walk for Network Embedding

Community Aware Random Walk for Network Embedding

Inductive Representation Learning on Large Graphs

Inductive Representation Learning on Large Graphs

A network-based normalized impact measure reveals successful periods of scientific discovery across disciplines

A network-based normalized impact measure reveals successful periods of scientific discovery across disciplines

「G=(V,E,A)をつかってV→R^dとなるVの要素の特徴を表すd 次元のベクトル(ただし d≪∣V∣)を学習することが目的」というのは言われてみればそう。各手法のアルゴリズムを清書しているのもよかった。

Network Embedding as Matrix Factorization: Unifying DeepWalk, LINE, PTE, and node2vec

「G=(V,E,A)をつかってV→R^dとなるVの要素の特徴を表すd 次元のベクトル(ただし d≪∣V∣)を学習することが目的」というのは言われてみればそう。各手法のアルゴリズムを清書しているのもよかった。

Network Embedding as Matrix Factorization: Unifying DeepWalk, LINE, PTE, and node2vec

LINE: Large-scale Information Network Embedding

LINE: Large-scale Information Network Embedding

node2vec: Scalable Feature Learning for Networks

node2vec: Scalable Feature Learning for Networks

arxiv.org/abs/1403.6652

arxiv.org/abs/1403.6652

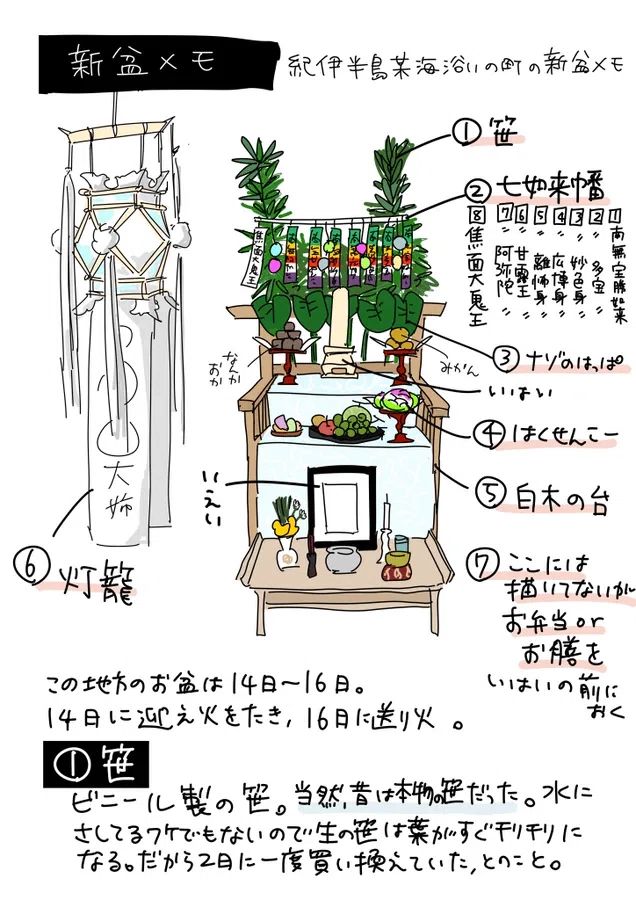

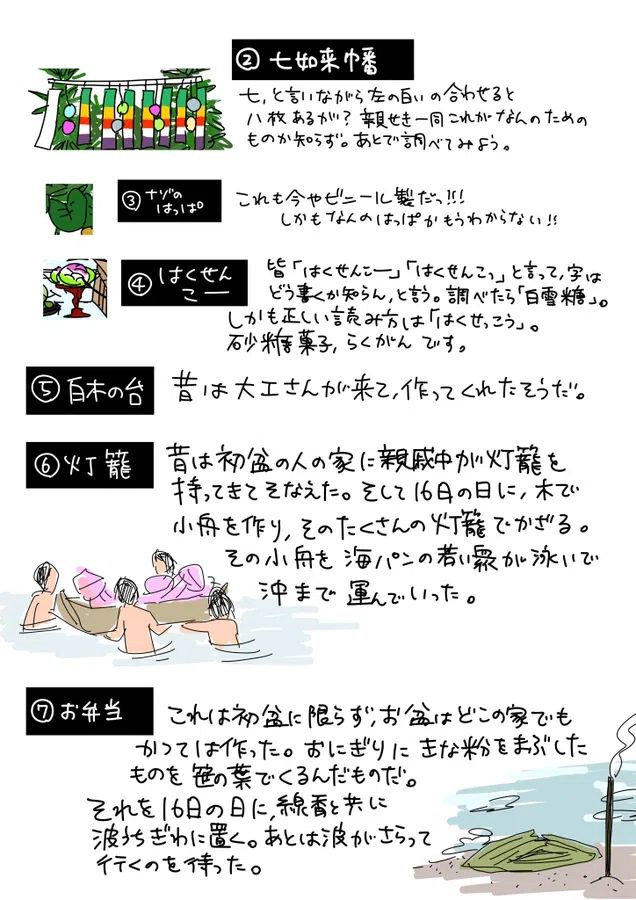

私の大学のゼミの先生(以前に漫画に描いた万葉集の先生ですね)は「風習は走り書きでも残しておかないと、本当にこの世から煙のように消えてなくなってしまうんです。後から誰も思い出せなくなる。」とよく言ってました。そういうわけで私は、別に研究者でもなんでもないんですが、せっせと生活をスケッチしたりメモで残したりします。

皆さんも今年のお盆の様子を、ちょっとメモしてみはいかがでしょう?

私の大学のゼミの先生(以前に漫画に描いた万葉集の先生ですね)は「風習は走り書きでも残しておかないと、本当にこの世から煙のように消えてなくなってしまうんです。後から誰も思い出せなくなる。」とよく言ってました。そういうわけで私は、別に研究者でもなんでもないんですが、せっせと生活をスケッチしたりメモで残したりします。

皆さんも今年のお盆の様子を、ちょっとメモしてみはいかがでしょう?